Vida

Por

Grupo Zócalo

Publicado el lunes, 17 de noviembre del 2025 a las 12:21

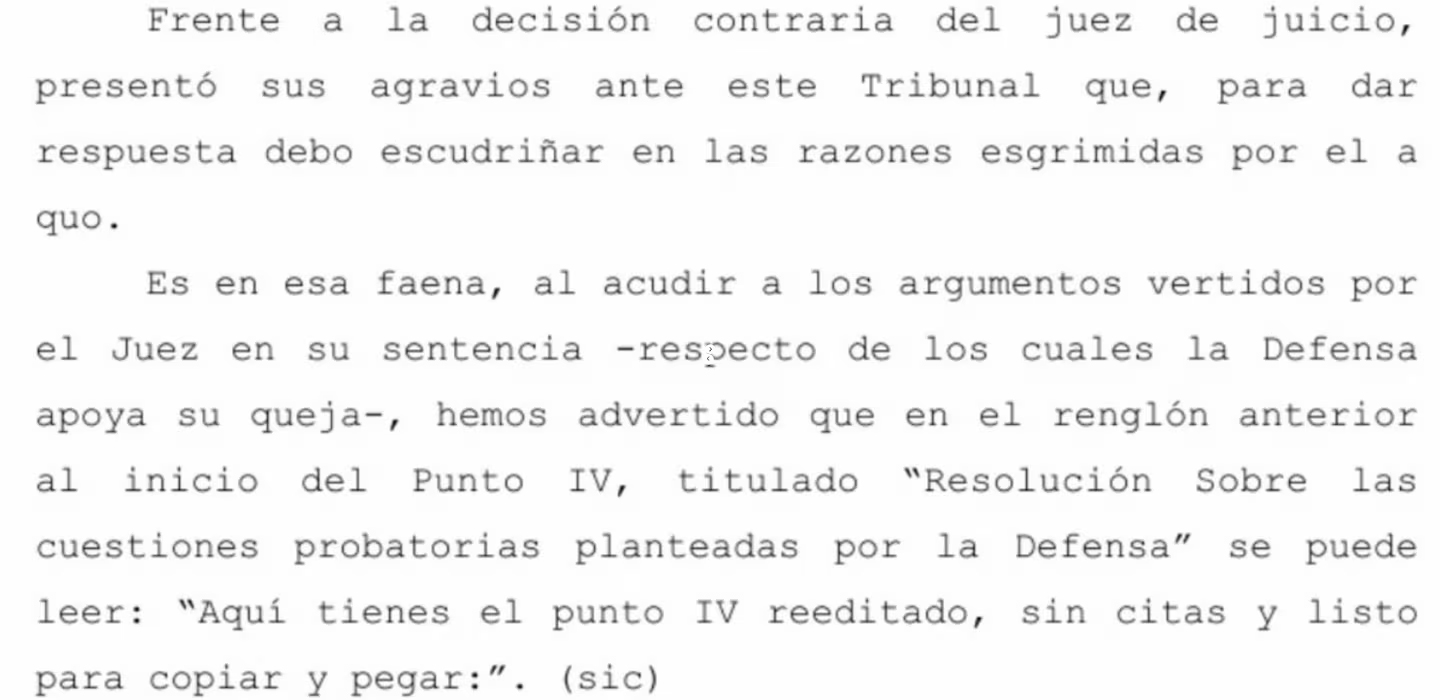

Argentina.- Un reciente fallo de la Cámara Penal de Esquel, en Argentina, ha anulado una condena a dos años y medio de cárcel después de que se descubriera que el magistrado había elaborado los fundamentos de la sentencia con ChatGPT, informa TN.

“Aquí tienes tu texto listo para copiar y pegar”, fue la frase que destapó el escándalo. En medio del documento del fallo aparecieron esas palabras, típicas de los asistentes de inteligencia artificial, que delataron al magistrado.

La sentencia original, dictada el 4 de junio de 2025 por el juez Carlos Rogelio Richeri, había condenado a Raúl Amelio Payalef a dos años y seis meses de prisión de cumplimiento efectivo por un robo simple.

Tras el descubrimiento, la Cámara determinó anular de oficio la sentencia y el juicio y ordenar un nuevo proceso con otro juez, mientras que el caso se ha remitido al Superior Tribunal de Justicia de Chubut para evaluar si el magistrado debe enfrentar algún tipo de consecuencia administrativa o disciplinaria.

Según la resolución, el magistrado no dejó constancia de cómo utilizó la IA ni del nivel de asistencia que recibió, lo que impide controlar la trazabilidad del razonamiento de la sentencia.

En el fallo, los camaristas expresaron: “Su utilización no permite, ahora, dilucidar si el juez recurrió a ella para ordenar la redacción de su sentencia o si ha sido el programa informático el que ideó la solución jurídica. No hay forma de conocer la dirección elegida por el juez”.

Además, agregaron que los principios de imparcialidad, justicia y equidad, responsabilidad institucional y transparencia, deben tenerse en cuenta a la hora de velar por la garantía y el respeto del debido proceso en el uso de la IA en el ejercicio de la función judicial.

Así, del fallo se desprende que la Cámara no evaluó ni modificó la culpabilidad del acusado, sino que anuló la sentencia por vicios en la forma de redacción y uso indebido de IA.

El uso de inteligencia artificial en la redacción de fallos judiciales no está exento de riesgos. Por un lado, los sistemas de IA pueden generar información incorrecta o inventada.

Por otro, si el juez incorpora datos personales de los involucrados en sus consultas, existe la posibilidad de que esa información quede almacenada o procesada por la empresa que desarrolla la IA, lo que plantea serias preocupaciones sobre privacidad y seguridad.

La provincia de Chubut tiene regulado el uso de inteligencia artificial en el poder judicial, estableciendo las siguientes reglas:

• Obligatoriedad de control humano efectivo, es decir, el juez debe supervisar cada respuesta. Sin embargo, en este caso no se hizo: el togado solo copió y pegó.

• Transparencia obligatoria declarando qué IA se usó, con qué datos y bajo qué instrucciones. En este caso, el juez no informó de ningún extremo.

• Confidencialidad, con la prohibición de volcar información sensible en sistemas de IA sin garantizar el anonimato, algo que tampoco hizo el juez de este caso.

• Prohibición de delegar decisiones.

Más sobre esta sección Más en Vida

Hace 22 horas

Hace 1 dia

Hace 1 dia

Hace 1 dia

Hace 1 dia

Hace 1 dia

Hace 1 dia

Hace 2 dias

Hace 2 dias

Hace 2 dias